Техническая оптимизация сайта — это основной шаг в продвижении сайта, он ориентирован на то, чтобы страницы загружались быстро, не было проблем с индексацией сайта, на них была хорошая графика, а с контентом было легко взаимодействовать.

- Что такое техническое SEO и как оно влияет на развитие сайта

- Скорость загрузки сайта

- Сканирование и индексация

- Структура сайта

- Качество контента

Что такое техническое SEO и как оно влияет на развитие сайта

Техническое SEO — это процесс приведения сайта в соответствие с техническими требованиями поисковой системы. Ключевыми элементами технического SEO являются:

- Сканирование — процесс, при котором поисковые роботы обходят страницы сайта для обнаружения и анализа контента.

- Индексация — добавление страниц в базу данных поисковой системы для дальнейшего ранжирования.

- Визуализация — корректное отображение контента (включая JavaScript, CSS) при сканировании роботами.

- Архитектура сайта — логичная структура страниц и внутренних ссылок, облегчающая навигацию пользователей и роботов.

Для высоких позиций в выдаче недостаточно обратных ссылок и высококачественного контента, ценного и релевантного поисковому запросу. Чем больше вы облегчаете жизнь Google, тем больше у вас шансов на высокое ранжирование.

Техническая оптимизация позволит улучшить или увеличить:

- Сканирование и индексирование страниц поисковыми роботами.

- Пользовательский опыт.

- Конверсии.

- Авторитетность сайта.

- Скорость загрузки страницы.

Последний пункт особенно важен. Предполагается, что скорость ответа системы должна имитировать задержку в общении между двумя людьми. Если она превышает четыре секунды, люди теряют интерес и уходят. В случае с интернет-магазинами это потеря продаж.

Кит Итон, технический журналист:

В компании Amazon подсчитали, что замедление загрузки страницы всего на секунду может приводить к потере продаж на 1,6 млрд долларов в год. Google подсчитал, что замедление выдачи поисковых результатов всего на четыре десятые секунды может привести к потере 8 млн запросов в день. А значит, будут потеряны миллионы показов рекламного контента

Как видите, низкая скорость загрузки сайта может повлиять на рост бизнеса. А это всего один элемент технического SEO, есть и другие. Подробно рассмотрим каждый из них.

Скорость загрузки сайта

Скорость загрузки сайта может напрямую влиять на ранжирование. Если вы можете выбрать только один параметр технического SEO, стоит остановиться на нем и разобраться, что влияет на скорость загрузки.

Краткий чек-лист ускорения сайта

- Настройка сети доставки содержимого (CDN)

- Оптимизация мобильной версии

- Сокращение количества перенаправлений

- Сжатие крупных файлов (изображения, видео)

- Использование плагинов кэширования

- Удаление неиспользуемых плагинов

- Очистка сторонних скриптов

Скорость загрузки и органический трафик

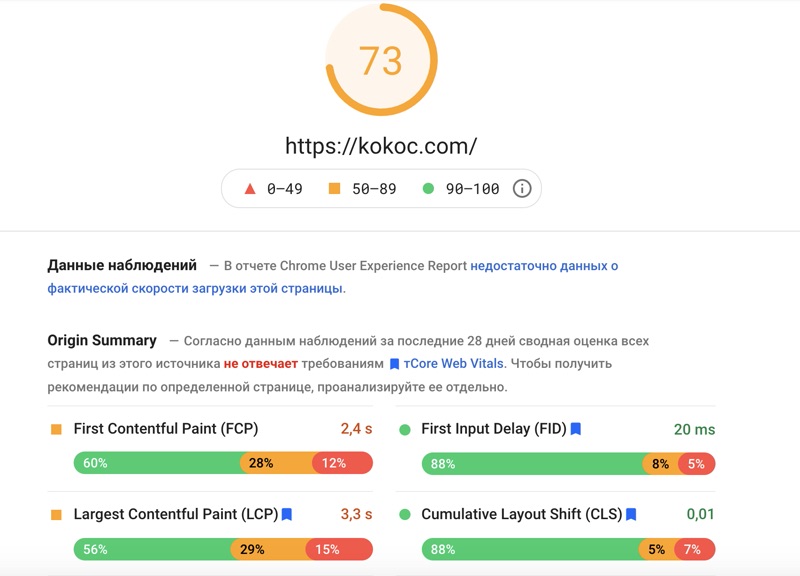

Быстрая скорость загрузки — не единственный фактор ранжирования в Google, но система его использует. С 2021 года Google также учитывает показатели Core Web Vitals — набор метрик пользовательского опыта, включающий LCP (Largest Contentful Paint), CLS (Cumulative Layout Shift) и INP (Interaction to Next Paint).

С помощью инструмента Google PageSpeed Insights вы можете быстро оценить скорость загрузки и получить рекомендации по улучшению Core Web Vitals.

Сеть доставки содержимого и время загрузки

Сеть доставки содержимого (CDN) сокращает трансфер данных между сервером кэша CDN и пользователем. Поскольку на перемещение файла требуется меньше времени, скорость загрузки становится быстрее.

Но CDN может работать как попало. Если не настроить ее правильно, скорость загрузки может сократиться. Если вы установили CDN, протестируйте время загрузки с ней и без нее, используя webpagetest.org.

Удобство мобильной версии

Оптимизация под мобильные платформы — один из ключевых факторов ранжирования. Проверить ее можно с помощью специального инструмента Google. Тест покажет, насколько оперативно страница работает на мобильных устройствах и насколько хорош пользовательский опыт.

Веб-приложения — еще одна вещь, на которую стоит обратить внимание для улучшения страниц. Например, Google рекомендует использовать ускоренные мобильные страницы (AMP), разработанные для более быстрой загрузки контента на мобильных устройствах.

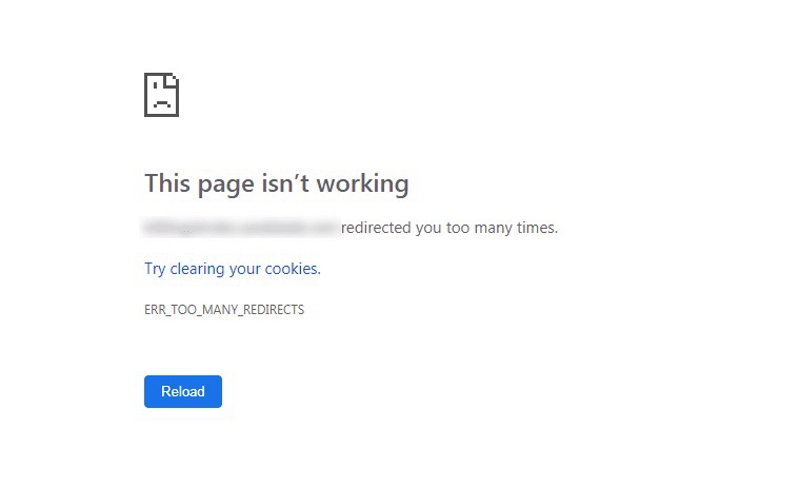

Перенаправление URL и скорость загрузки

Перенаправление URL помогает убедиться, что нет битых ссылок, которые ведут на тупиковые страницы, или обойти проблемы, связанные со ссылочной ценностью. Но большое количество перенаправлений замедляет работу сайта. Чем их больше, тем медленнее будет загружаться страница.

Поэтому важно делать небольшое количество перенаправлений. Замкнутый круг переадресаций (много перенаправлений ведут на одну страницу) также может привести к проблемам с загрузкой сайта и появлению ошибок.

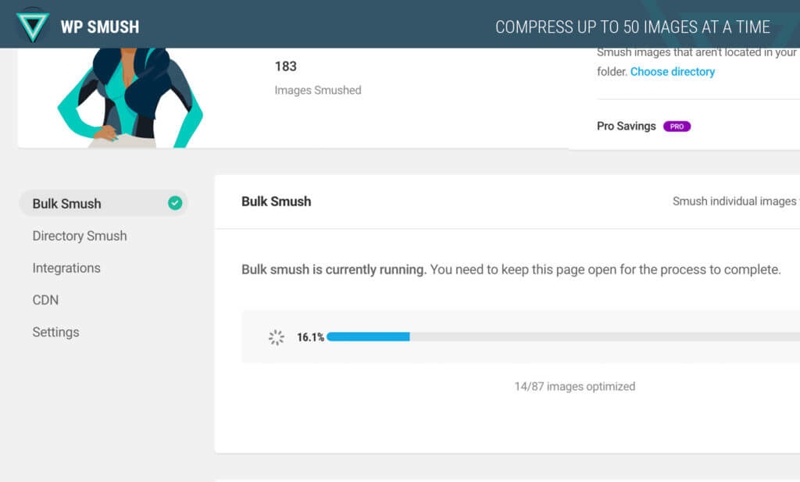

Крупные файлы и скорость загрузки

Крупные файлы, например фотографии и видео с высоким разрешением, загружаются дольше. Их сжатие может сократить время загрузки и улучшить пользовательский опыт.

Для таких типов файлов как GIF, JPEG и PNG есть немало способов сжатия. Чтобы сохранить свое время, выполняйте массовое сжатие. Для этого подходят инструменты tinypng.com и compressor.io. Лучше всего выбирать файлы типа PNG. Они сохраняют более высокое качество при сжатии.

Для CMS WordPress есть специальные плагины: SEO Friendly Images и Smush.

Обычно в инструментах предлагается вариант сохранения для интернета. Это поможет убедиться, что файлы не слишком большие.

Однако здесь важно понять, как сжатые файлы влияют на пользовательский опыт. Если пользователям показываются изображения низкого качества и они уходят с сайта, не стоит зацикливаться на размере файлов.

Плагины кэширования и временное хранение

Когда пользователь посещает новый сайт, на компьютере сохраняется кэш. При возвращении на сайт сохраненные файлы помогут быстрее получить нужную информацию.

Комбинирование плагинов W3 Total Cache и Autoptimize может улучшить кэширование и скорость загрузки.

Плагины

На сайт можно легко добавить любое количество плагинов. Но чем их больше, тем медленнее загрузка страницы. Ускорить ее можно, удалив ненужные.

Проверить, является ли плагин нужным или лишним, можно в Google Analytics. Можно вручную отключать по одному плагину и тестировать скорость загрузки.

Тесты в режиме реального времени помогут понять, как отключение определенных плагинов влияет на конверсию. Например, отключите плагин подписки и посмотрите, как это повлияет на коэффициент подписок.

В качестве альтернативы можно использовать Pingdom. Он определит, влияют ли плагины на скорость загрузки.

Сторонние скрипты

По данным SEO-агентства Backlinko, каждый сторонний скрипт добавляет 34 миллисекунды ко времени загрузки страницы. Некоторые скрипты важны, например Google Analytics. Но, возможно, на вашем сайте есть и другие, которые можно удалить.

Они часто появляются, когда сайт обновляется, а неиспользуемые ресурсы не удаляются. Артефакты из старых версий влияют на скорость загрузки и пользовательский опыт. Можно использовать инструмент Purify CSS, чтобы удалить лишнее. Если в вашей команде есть разработчик, убедитесь, что он выполняет чистку систематически.

Сканирование и индексация

Поисковые системы должны иметь возможность идентифицировать, сканировать, визуализировать и индексировать страницы. Медленный сайт потребляет больше краулингового бюджета (crawling budget) — ограниченного ресурса, который поисковые роботы выделяют на обход вашего сайта. Оптимизация скорости помогает роботам эффективнее сканировать страницы и быстрее индексировать обновления.

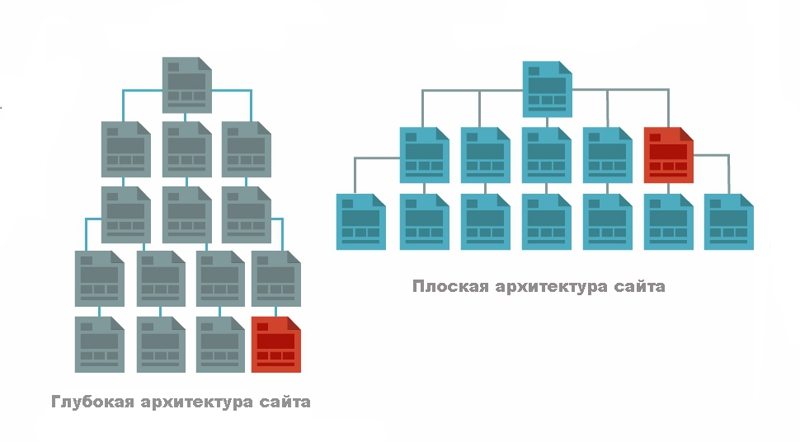

Архитектура сайта

Поисковой системе сложнее идентифицировать страницы, которые не имеют прямой связи с домашней. Особенно если к ним ведет слишком много внутренних ссылок.

Плоская архитектура помогает избежать этой проблемы. Такое расположение страниц сайта помогает совершать минимум кликов для попадания на внутренние страницы со стартовой.

Использование плоской структуры с внутренними ссылками на релевантные страницы помогает поисковым системам индексировать контент на сайте. Стартовые страницы обычно имеют больший авторитет. Связь между ними помогает поисковым роботам их обнаруживать.

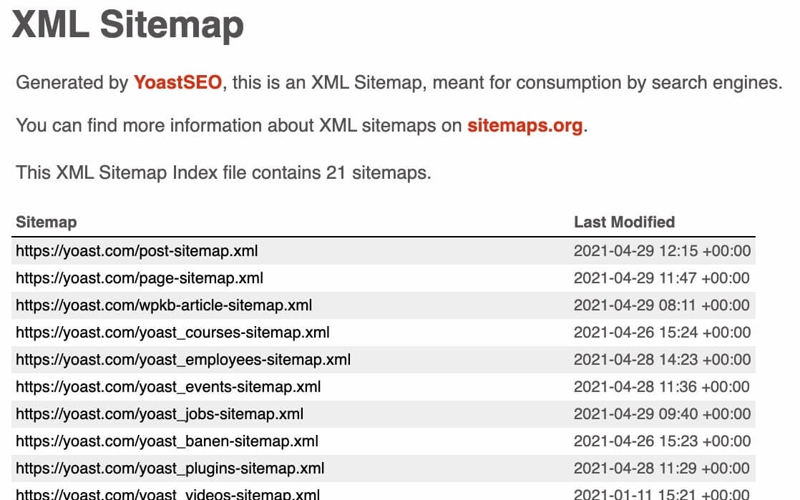

XML sitemap

XML sitemap предлагает список всех наиболее важных страниц на сайте. Хотя это кажется менее важным, чем оперативность мобильной версии или другие факторы ранжирования, Google по-прежнему учитывает его.

XML sitemap содержит информацию о том:

- Когда страница в последний раз изменялась.

- Как часто страницы обновляются.

- Какие приоритетные страницы есть на сайте.

С помощью Google Search Console вы можете проверить XML sitemap, который видит поисковая система при сканировании сайта.

Используйте перечисленные ниже инструменты, чтобы обнаруживать ошибки сканирования и проверять индексацию страниц сайта.

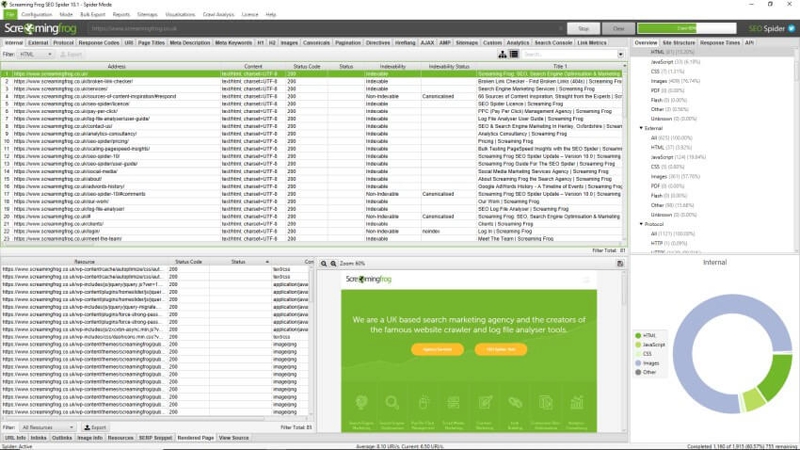

Screaming Frog

Для чего этот инструмент: Screaming Frog считается золотым стандартом поиска ошибок сканирования и индексации.

При запуске проверки инструмент извлечет данные с сайта и проведет проверку на распространенные проблемы, например, найдет битые ссылки. Эта информация поможет внести быстрые изменения — исправить ошибку 404, или запланировать долгосрочные планы, например, обновление метаописаний на сайте.

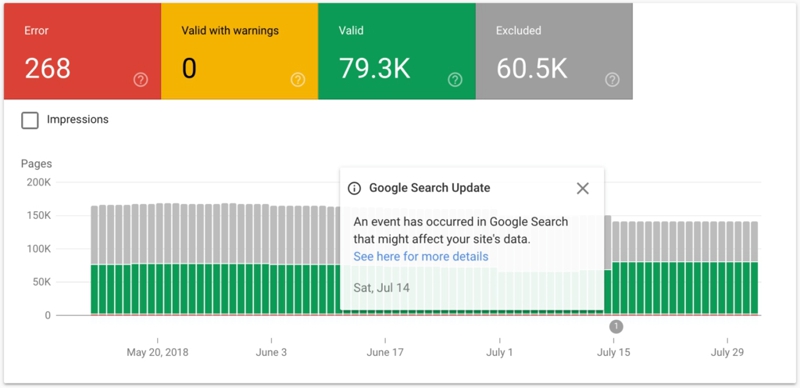

Google Search Console

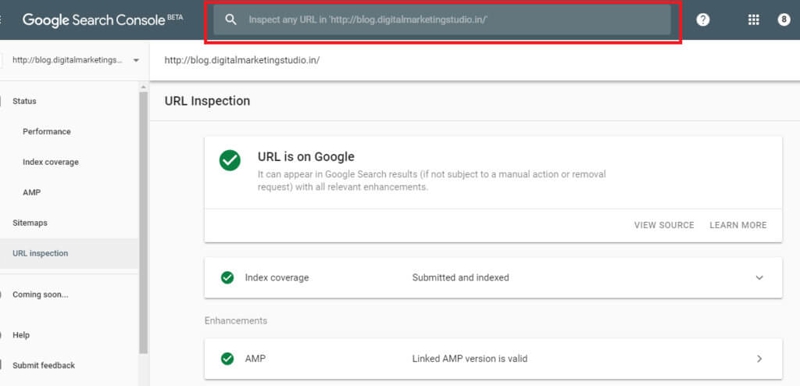

Для чего этот инструмент: Google Search Console предоставляет полноценный отчет об индексировании, показывающий страницы, которые Google не может индексировать полностью или визуализировать.

Иногда страницы могут индексироваться Google, но визуализация у них неверная. Это значит, что Google может индексировать страницу, но не может на 100 % отсканировать контент.

Структура сайта

Структура сайта — основа всех остальных технических элементов. Она влияет на структуру URL и файл robots.txt, который определяет, какие страницы Google может сканировать и индексировать.

Многие ошибки сканирования и индексации — результат плохо продуманной структуры сайта. Создание сайта с простой навигацией как для пользователей, так и для поисковых роботов поможет избежать ошибок в будущем.

Коротко говоря, простая структура сайта помогает с другими задачами технического SEO. Она логично связывает страницы, и их порядок не вызывает вопросов как у людей, так и у поисковых роботов.

Страницы-сироты — страницы, отрезанные от остальных из-за отсутствия внутренних ссылок. Стоит избегать их создания, потому что поисковые роботы могут пропустить их при сканировании и индексации.

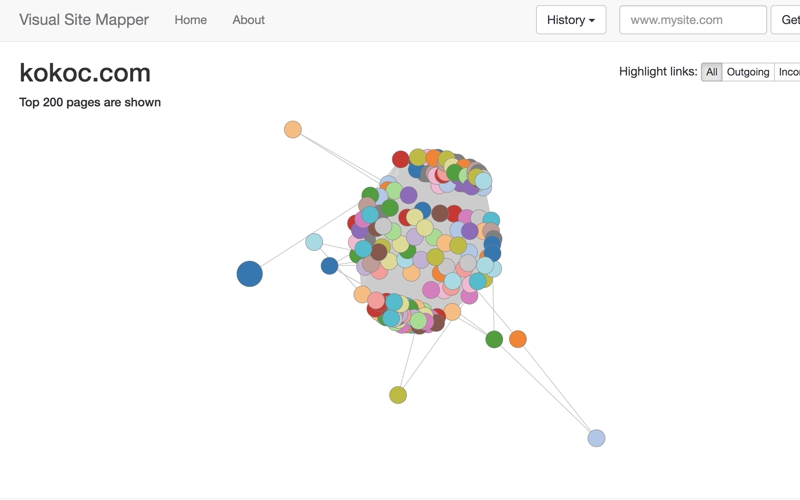

Такой инструмент как Visual Site Mapper помогает визуально оценить структуру сайта и понять, насколько хорошо страницы связаны друг с другом. Хорошая структура внутренних ссылок демонстрирует связь контента для Google и пользователей.

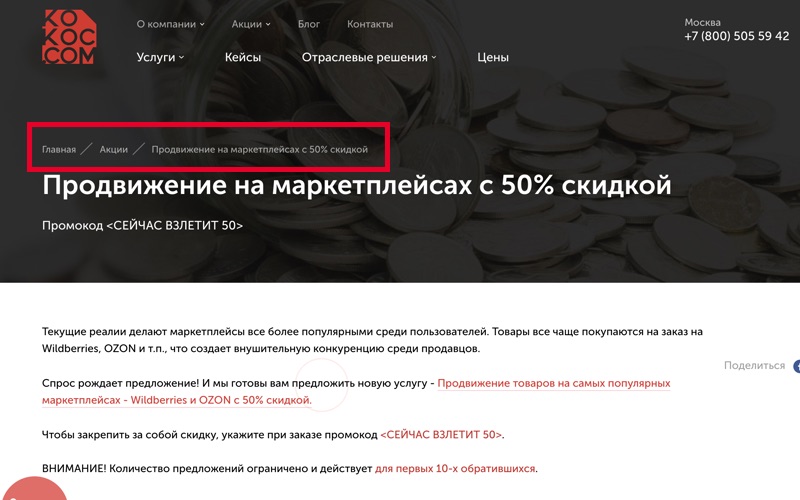

Навигационная цепочка, или Хлебные крошки

Навигационная цепочка — часть интерфейса, показывающая путь от начального элемента до того, который просматривается пользователем в данный момент. Навигационная цепочка позволяет автоматически добавлять внутренние ссылки на другие страницы сайта.

Это помогает пользователям и поисковым системам быстрее находить нужную информацию.

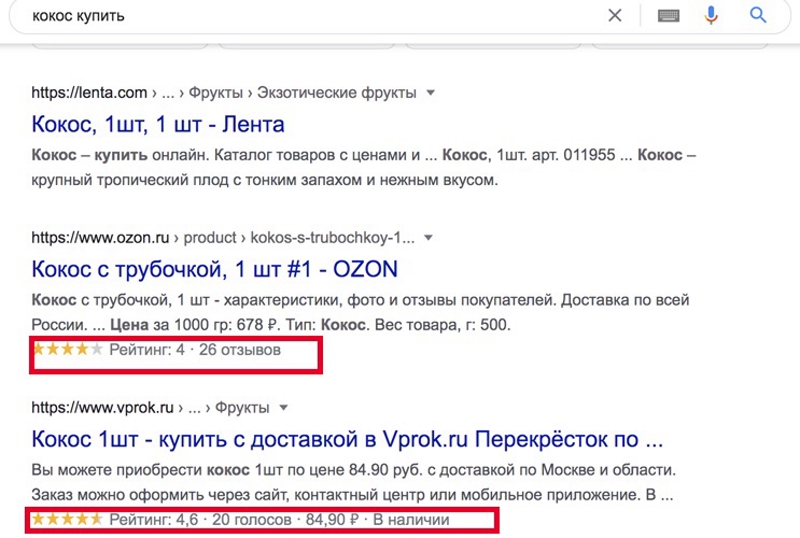

Структурированные данные

Использование разметки структурированных данных помогает поисковым системам лучше понимать ваш контент. Бонусом вы можете подключить расширенные результаты, которые увеличивают кликабельность контента.

Наиболее распространенные типы разметки Schema.org включают:

- Product — для товарных страниц интернет-магазинов (цена, наличие, рейтинг).

- Organization — для главной страницы компании (название, логотип, контакты).

- Article — для блогов и новостных публикаций (автор, дата публикации, заголовок).

- FAQ — для страниц с вопросами и ответами.

У Google есть собственный инструмент «Мастер разметки структурированных данных», который поможет создать новые теги.

Структура URL

Длинные сложные URL, в которых присутствуют случайные цифры, буквы и специальные символы, путают пользователей и поисковые системы.

URL должны отличаться простотой и согласованностью. В таком случае пользователи и поисковые системы поймут, в каком разделе сайта находятся.

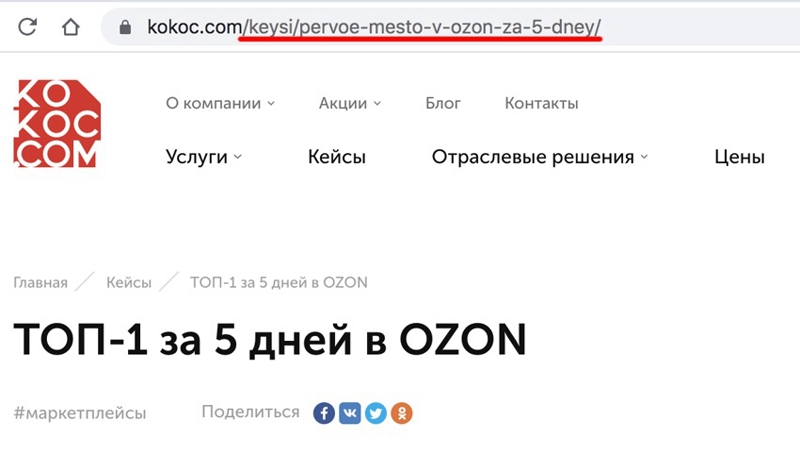

Например, на сайте агентства «Кокос» все страницы с кейсами содержат «/keysi/subfolder», чтобы помогать Google определять страницы в категорию «Кейсы».

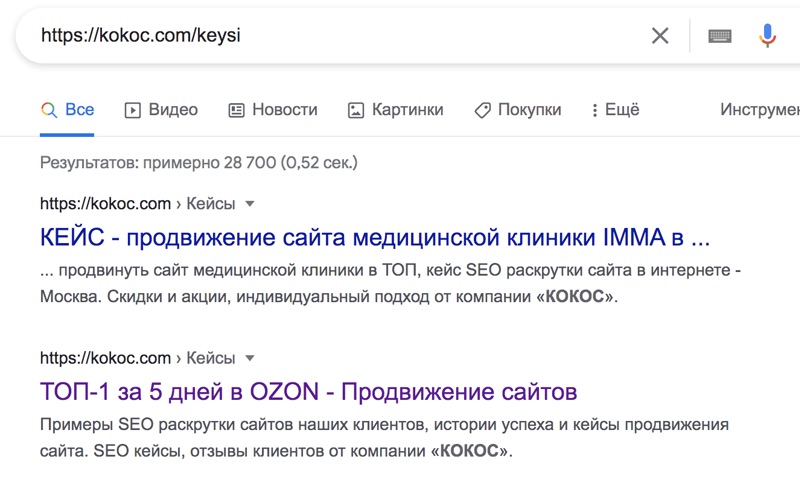

Google понимает и обратную связь. Если ввести в поиск https://kokoc.com/keysi, в выдаче отобразятся релевантные результаты с кейсами, представленными в папке.

Качество контента

Высококачественный контент — один из сильнейших активов сайта. Рассмотрим его с технической стороны.

Дублированный контент

Создание оригинального высококачественного контента — защита сайта от проблем с дублированным контентом. Дублированный контент может стать проблемой даже при высоких стандартах качества.

Если система управления содержимым (CMS) создает множество версий одной страницы с разным URL — это дублированный контент. Он присутствует на всех крупных сайтах в той или иной степени. Однако проблема возникает только в том случае, если он проиндексирован.

Чтобы исключить эту проблему, добавьте тег noindex на страницы с дублированным контентом. Проверить теги можно с помощью Google Search Console.

Если страница доступна для индексации Google, вы увидите сообщение «URL есть в индексе Google». Это значит, что тег noindex выставлен неверно. А вот сообщение «URL нет в индексе Google» подтвердит правильную работу тега. Не забывайте, что Google может потребоваться несколько дней или недель, чтобы заново просканировать страницу и понять, что ее больше не нужно индексировать.

Использование robots.txt

Если на вашем сайте есть дублированный контент, его не обязательно удалять. Вместо этого вы можете запретить поисковым роботам сканировать и индексировать его.

Для этого создайте файл robots.txt. В список исключений можно добавить не только дублированный контент, но и страницы-сироты.

Канонические URL

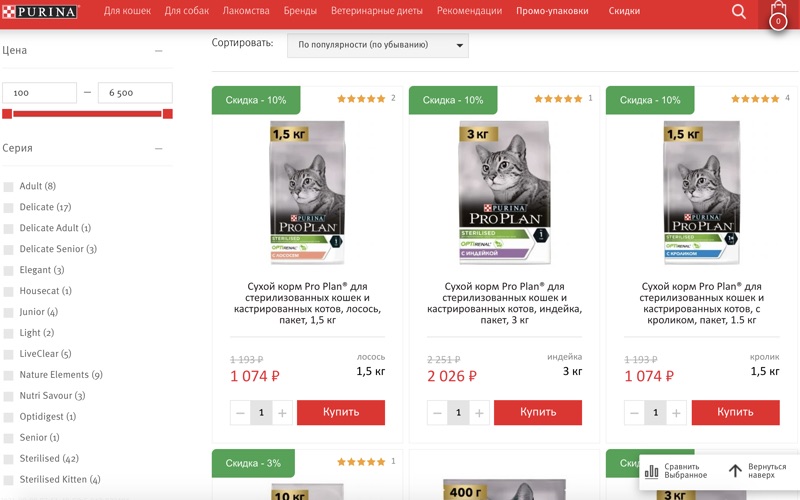

Для большинства страниц с дублированным контентом будет достаточно добавления тега noindex. Но как насчет страниц с похожим контентом? Часто такими бывают продуктовые страницы.

Например, сайт Purina продает корма для животных, и страницы будут отличаться лишь изображениями и описанием.

Без канонических тегов список одинаковых продуктов с небольшими различиями приведет к созданию отдельных URL для каждого из них. С каноническими тегами Google поймет, какую страницу считать основной, а какие ее вариациями. При этом последние дублированным контентом считаться не будут.

Нужен ли консультант по техническому SEO или аудит можно сделать самому?

Проводить технический аудит нужно регулярно. Для небольшого сайта достаточно выполнять его каждые шесть месяцев. Для крупных сайтов, на которые добавляется много контента, стоит утвердить график раз в квартал. Это поможет отслеживать технические факторы (далее мы их разберем), факторы внутренней оптимизации (например, контент) и внешней оптимизации (например, обратные ссылки).

Самостоятельно провести аудит можно с помощью инструмента Ahrefs. Это дешевле и чаще быстрее, чем нанимать специалиста или обращаться в агентство.

Однако консультация опытного специалиста может быть важна, если:

- Вы запускаете новый сайт и хотите убедиться, что настройки верные.

- Вы меняете старый сайт на новый и хотите провести миграцию без перебоев.

- У вас несколько сайтов и вы хотите понять, оптимизировать ли каждый по отдельности или все вместе.

- Вы предлагаете страницы на нескольких языках и хотите убедиться, что все версии верно настроены.

Заключение

Оптимизация технического SEO — не универсальный процесс. Есть элементы, которые важны для одних сайтов, но другим не подходят. Это будет зависеть от вашей аудитории, предполагаемого пользовательского опыта, клиентского опыта, бизнес-целей и прочего.

Разобравшись в основах технического SEO, вам будет проще создать страницы, которые нравятся пользователям и поисковым системам. Вы также сможете самостоятельно выполнять аудит технического SEO и будете понимать профессиональные методы работы.

.png)

.png)

.png)